一键安装包

通过一键安装包进行安装

| |

选择 1 安装 ComfyUI

获取 Ngrok Token

通过注册登录获取 Token

然后在容器中设置你的 Token

| |

运行 ComfyUI

运行前可使用镜像加速,通过Manager下载时会生效 export HF_ENDPOINT=“https://hf-mirror.com”

服务通过 8188 端口启动

| |

使用 Ngrok 监听 8188 端口

| |

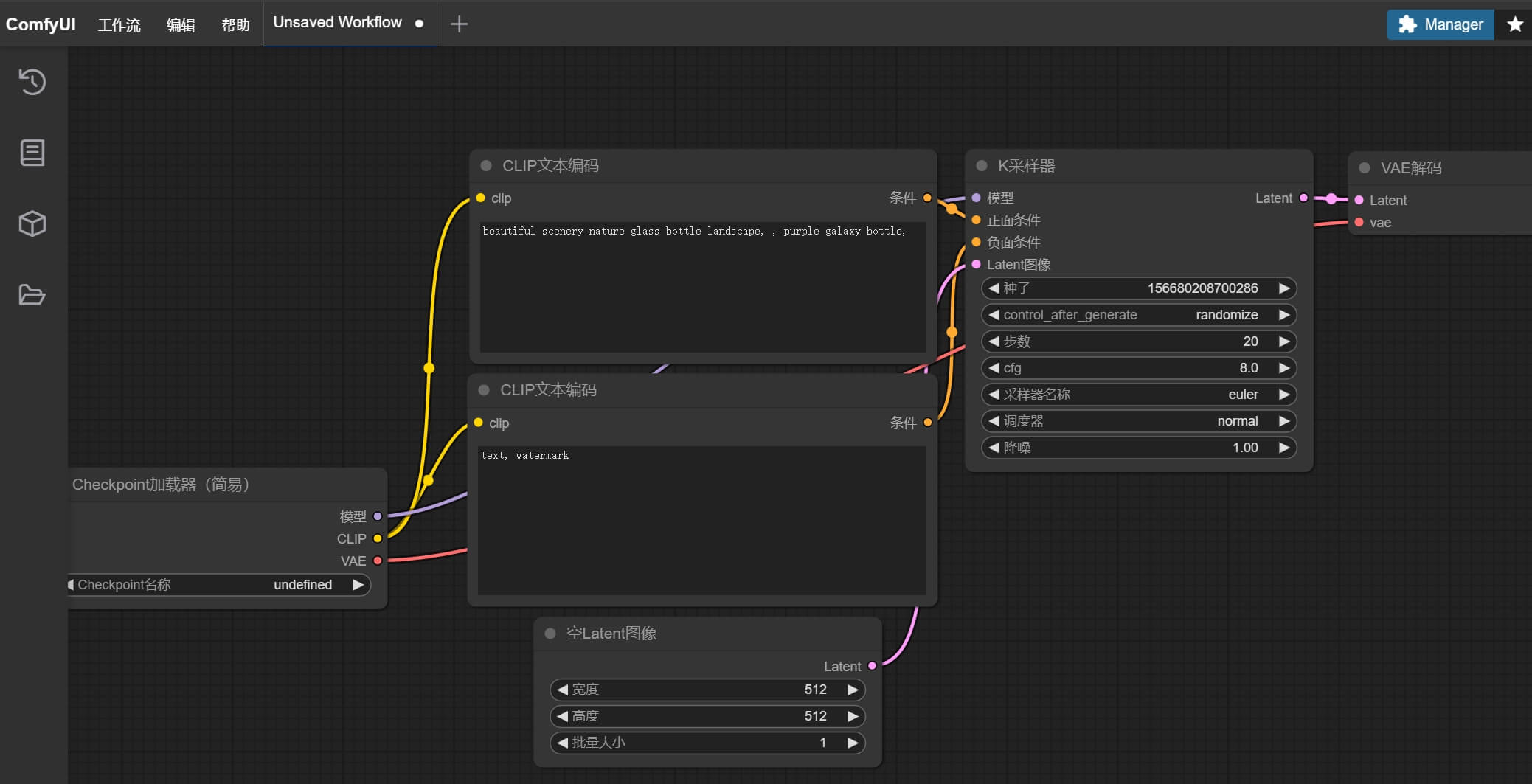

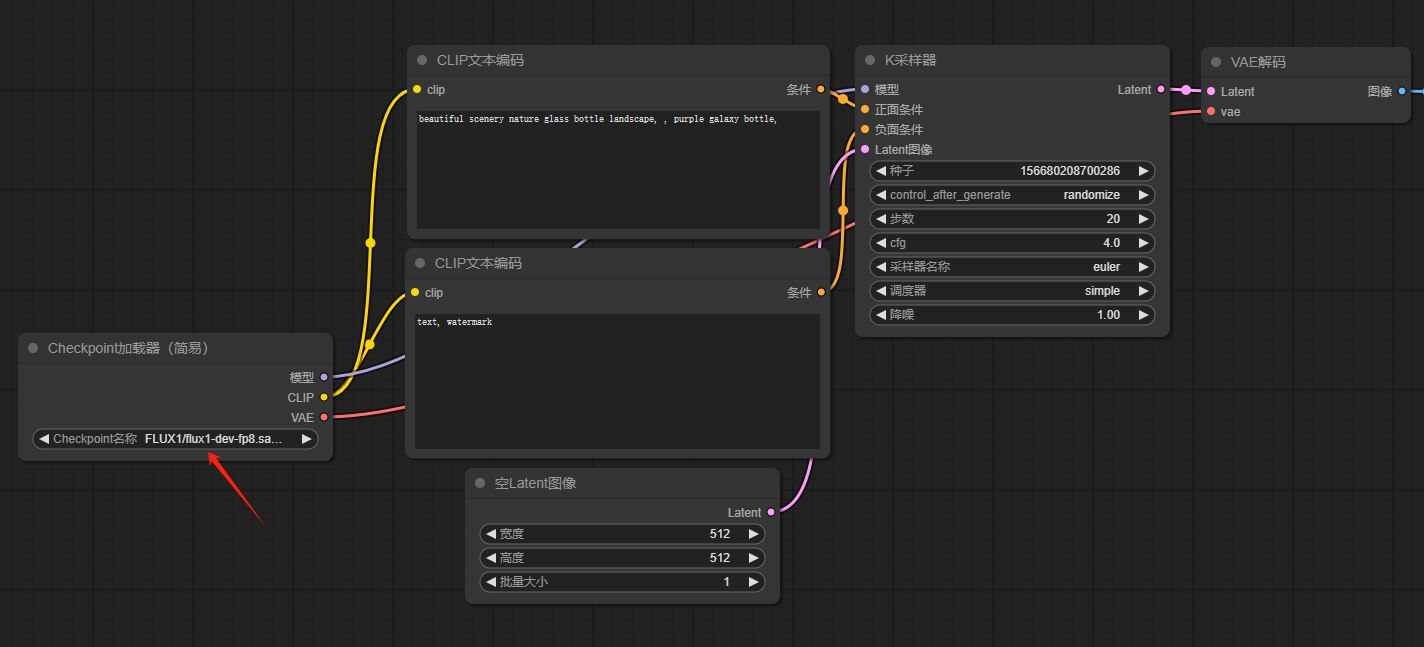

然后我们就可以打开 ComfyUI,就会看到默认打开了一个简易的工作流

下载模型

自动安装方式

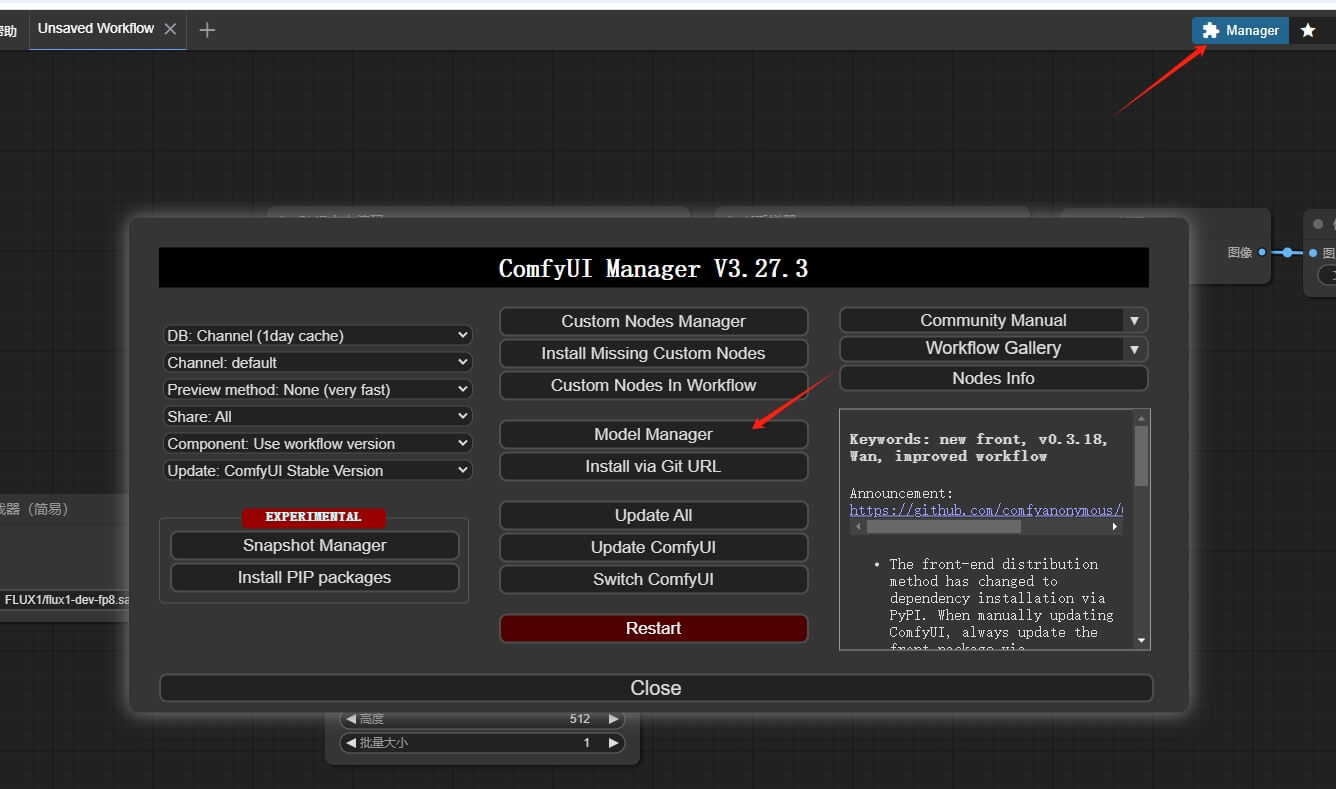

通过 ComfyUI 的 Manager 功能下载对应的模型

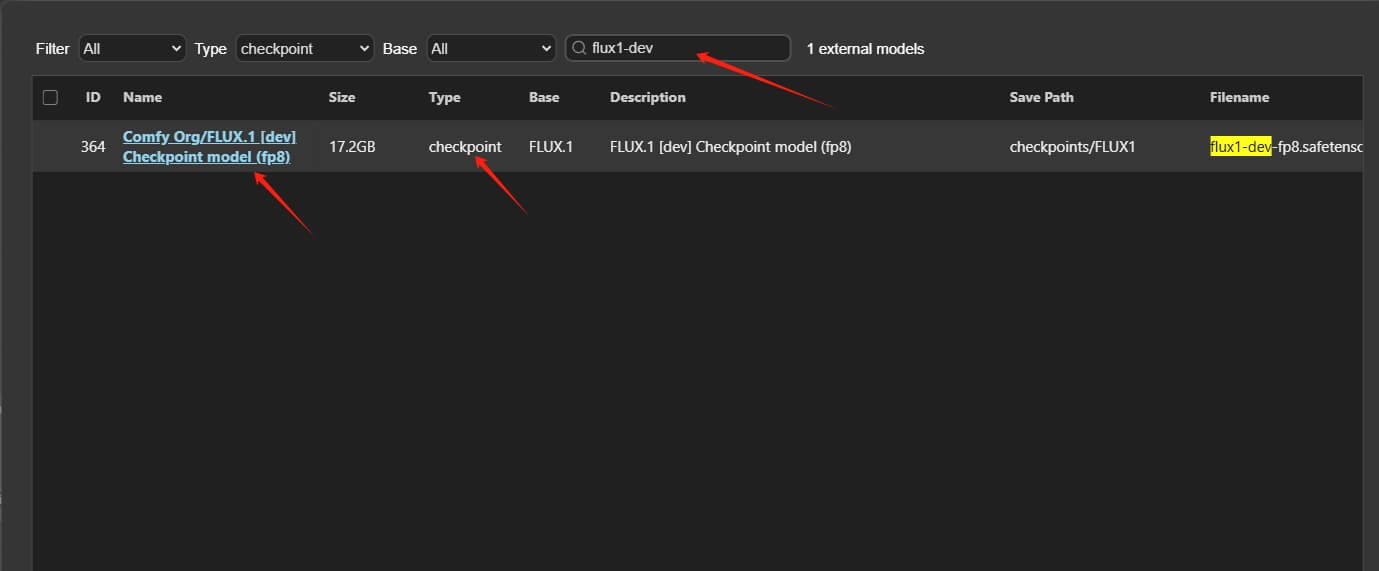

Flux.1 模型

选择 Comfy Org/FLUX.1 [dev] Checkpoint model (fp8)

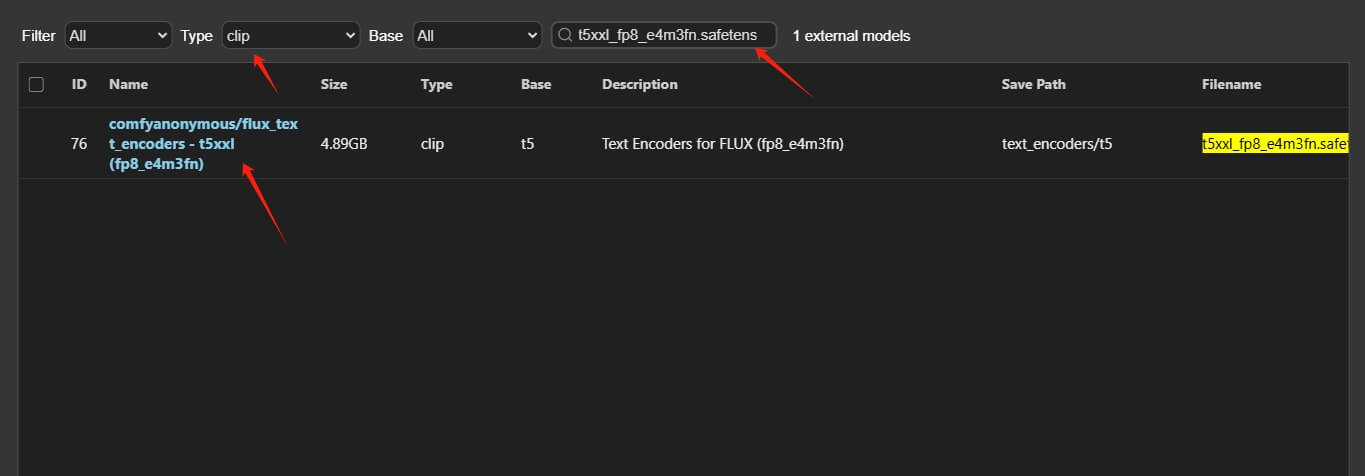

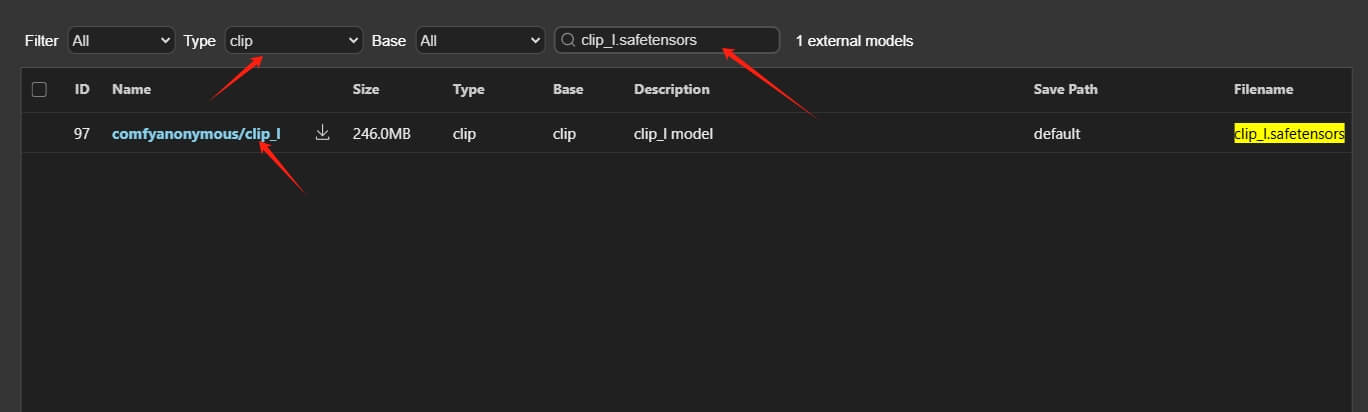

CLIP 模型

选择 comfyanonymous/flux_text_encoders - t5xxl (fp8_e4m3fn)

选择 comfyanonymous/clip_l

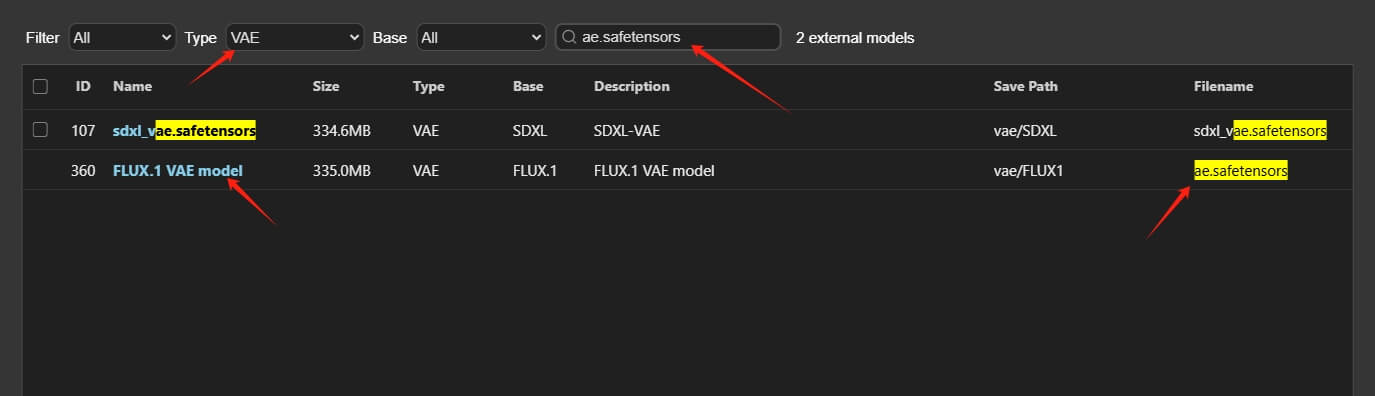

VAE 模型

选择 FLUX.1 VAE model

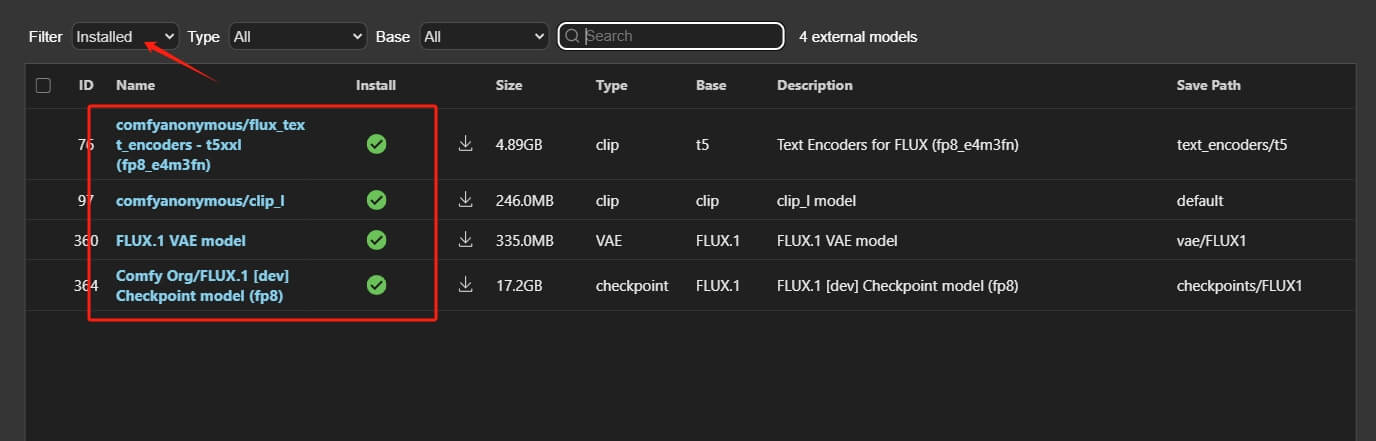

安装完成

一共4个模型需要安装

手动安装方式

需要自行到 Huggingface 上下载对应的模型

Flux.1 模型

使用量化的模型,最低 12G 显存可跑

https://huggingface.co/Kijai/flux-fp8/blob/main/flux1-dev-fp8.safetensors

下载的模型文件放到 ComfyUI/models/unet/ 目录下

CLIP 模型

t5xxl_fp8_e4m3fn.safetensors

https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/t5xxl_fp8_e4m3fn.safetensors

clip_l.safetensors

https://huggingface.co/comfyanonymous/flux_text_encoders/resolve/main/clip_l.safetensors

下载的 CLIP 模型放到 ComfyUI/models/clip/ 目录中

VAE 模型

ae.safetensors

https://huggingface.co/black-forest-labs/FLUX.1-schnell/resolve/main/ae.safetensors

下载的 VAE 模型存放至 ComfyUI/models/vae/ 目录

运行效果

在 Checkpoint 加速器 中,选择下载好的 FLUX1 模型

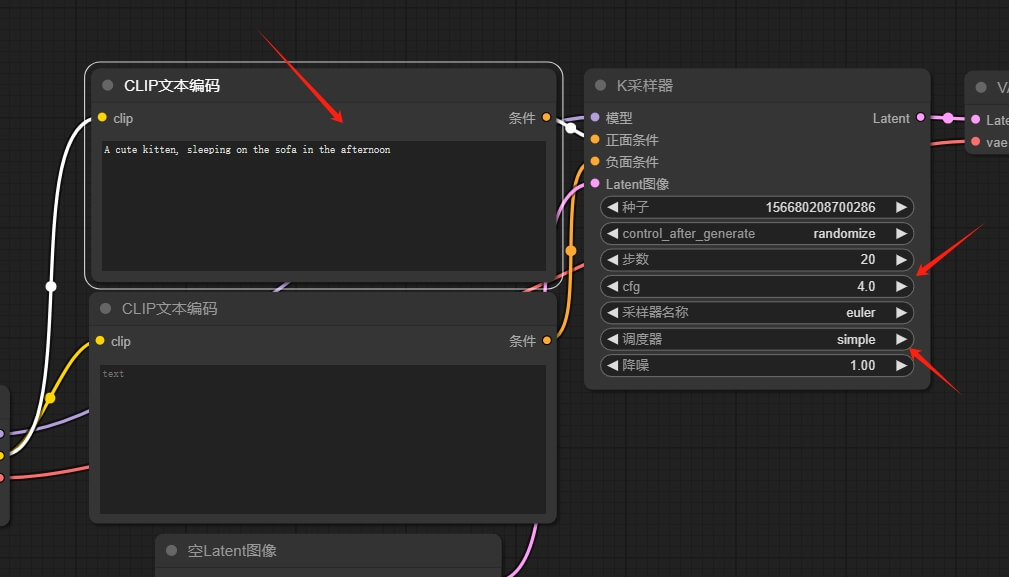

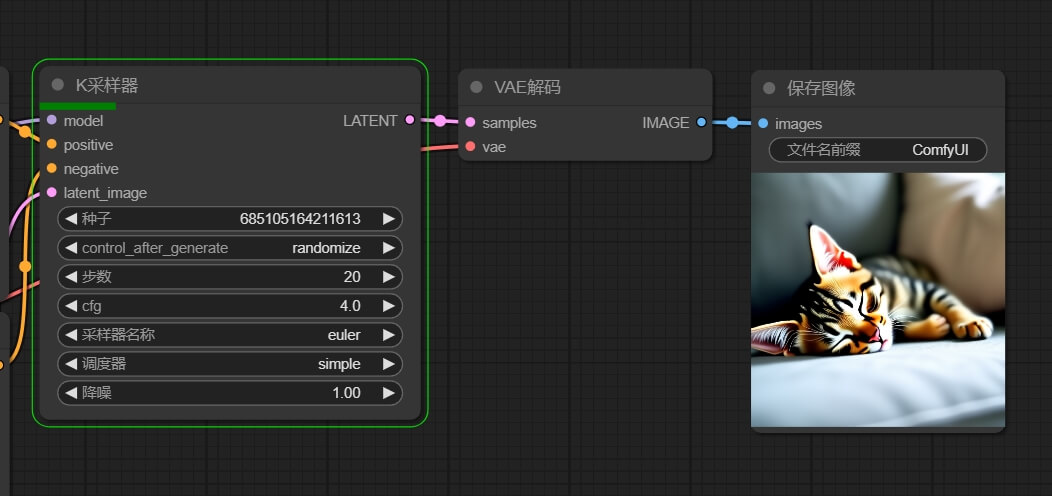

画一只小猫

让它画一只可爱的小猫,午后,睡在沙发上,转为一个英文提示词 A cute kitten, sleeping on the sofa in the afternoon,同时调整一下 采样器 的默认值

点击下方蓝色的 执行 按钮,看看运行效果

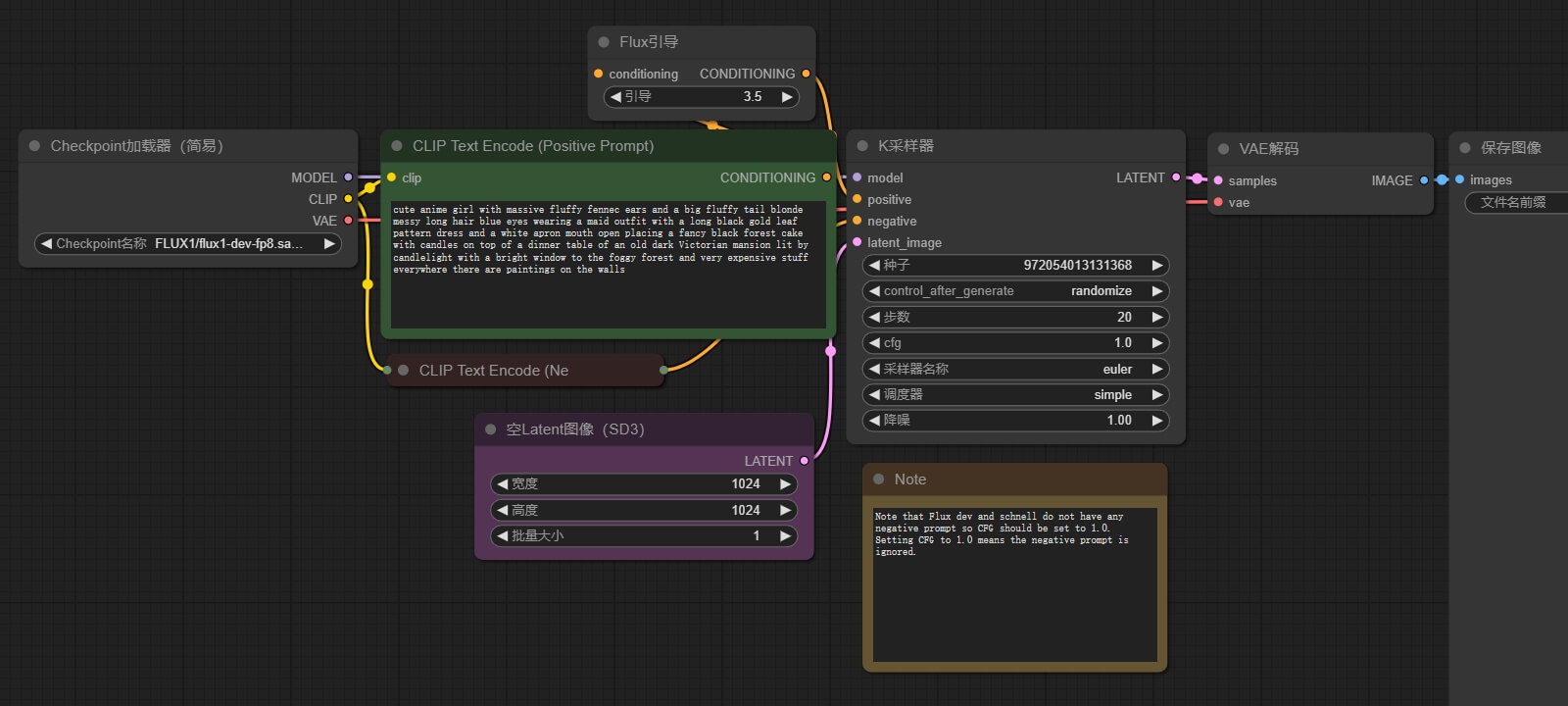

官方的工作流

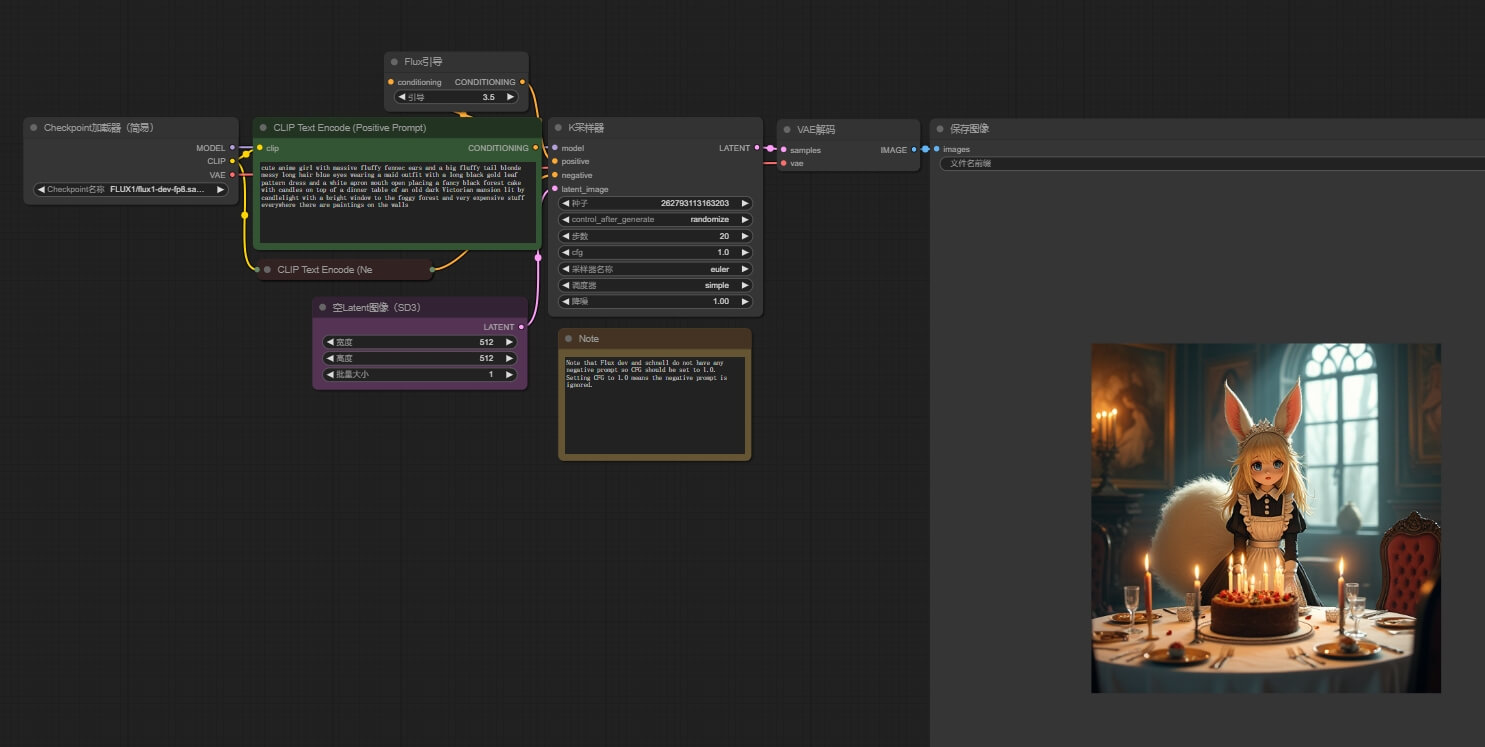

官方提供了一个基于 Flux dev FP8 Checkpoint 模型的工作流,flux_dev_checkpoint_example.json,打开后如下图所示

获取工作流文件,关注公众号回复 flux01

运行后就可以看到效果

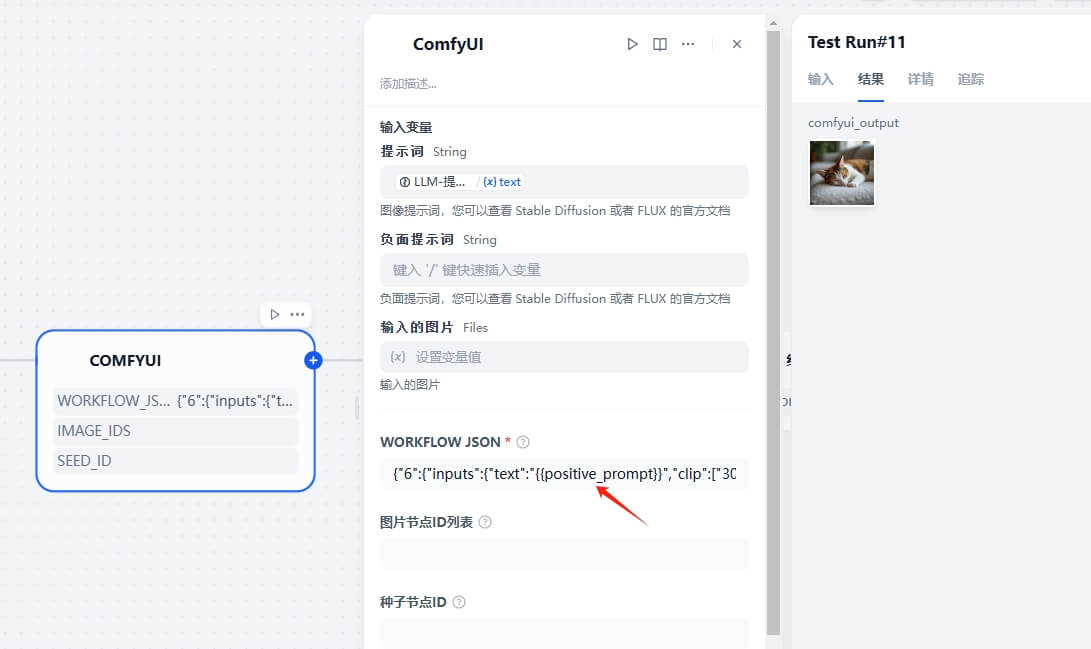

结合 Dify 使用

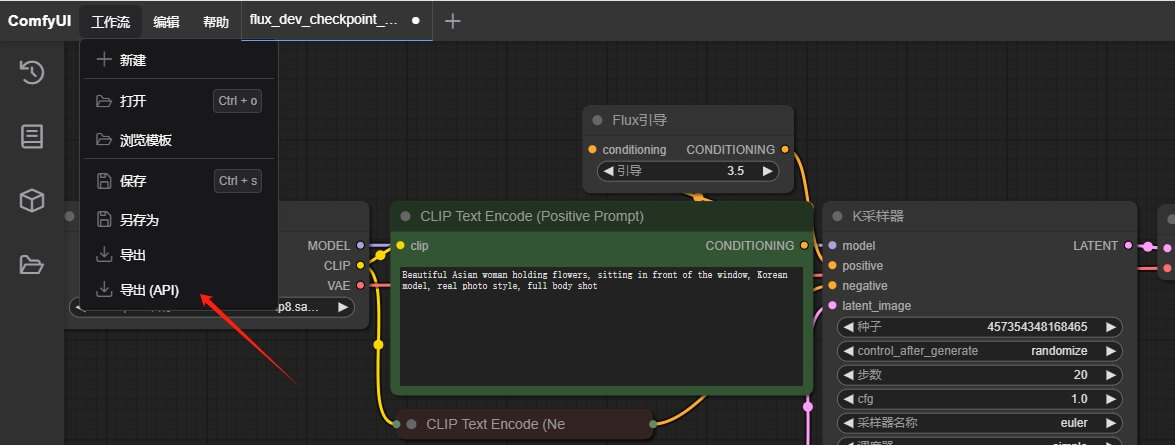

导出 API 所需 json 文件

先在 设置 中,开启开发者模式

点击 菜单 栏中的 工作流,选择导出 API 文件

Dify 安装 ComfyUI 插件

搜索并安装 ComfyUI 插件,然后添加到工作流中

首次使用需要授权,地址中填入 Ngrok 访问的地址

然后下方的 WORKFLOW JSON 中添加上面导出的 API json 文件里面的内容

重点:修改第一个 inputs 里面的 text 的值为 {{positive_prompt}},这样 API 接口才会接收到传入的提示词内容