Claude Code 配置免费接入智谱AI、魔搭等第三方模型

众所周知,在国内使用 Claude Code 是比较麻烦的,要么就配置国内的 中转API 来跳过官方的授权登录,要么就提供一个稳定的魔法网络。

接下来主要介绍目前有哪些白嫖的第三方模型,并且它们分别如何在 Claude Code 中配置使用。

智谱AI

现在官方新用户注册免费赠送 2000万 tokens 体验包

不过只适用指定的场景,不是全部模型都能够使用哦,而且只有三个月的有效期。

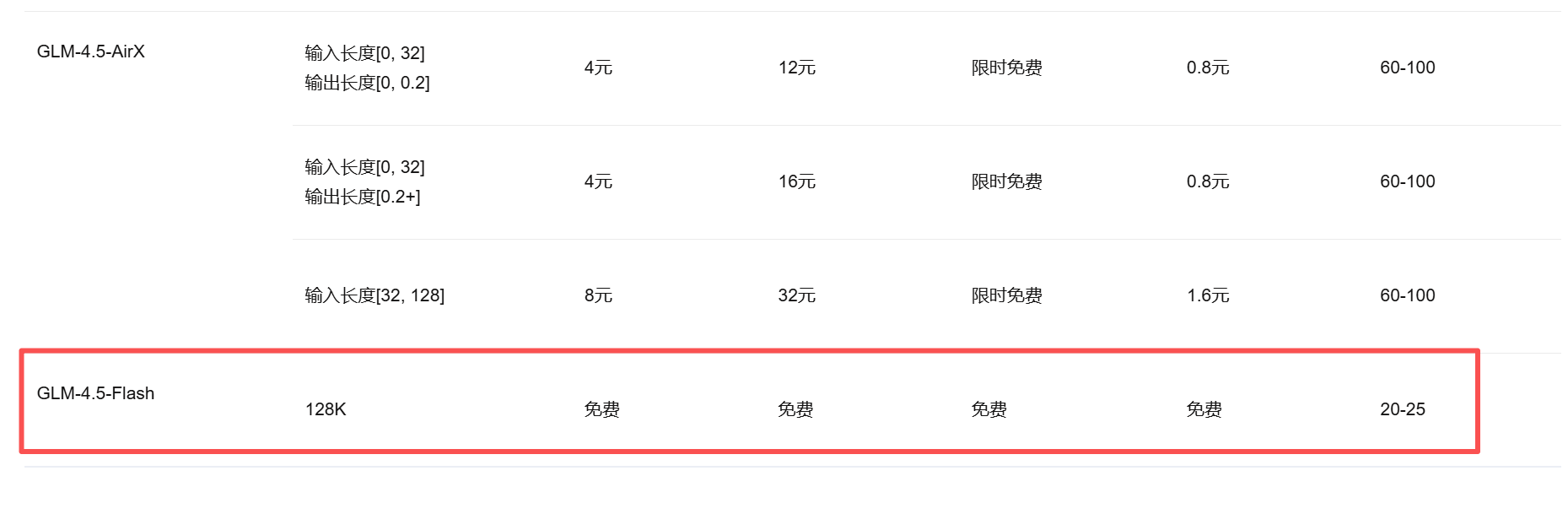

而当前的 GLM-4.5-FLASH 模型是能够免费使用的,并且官方的速率限制只会限制并发数,所以个人使用是没有问题的。

配置

先到后台个人中心创建一个 API KEY

主要是在环境变量中配置 ANTHROPIC_AUTH_TOKEN 和 ANTHROPIC_BASE_URL,其中要注意的是 ANTHROPIC_BASE_URL 必须要使用 ANTHROPIC API 兼容格式的接口地址。大概配置如下:

| |

使用

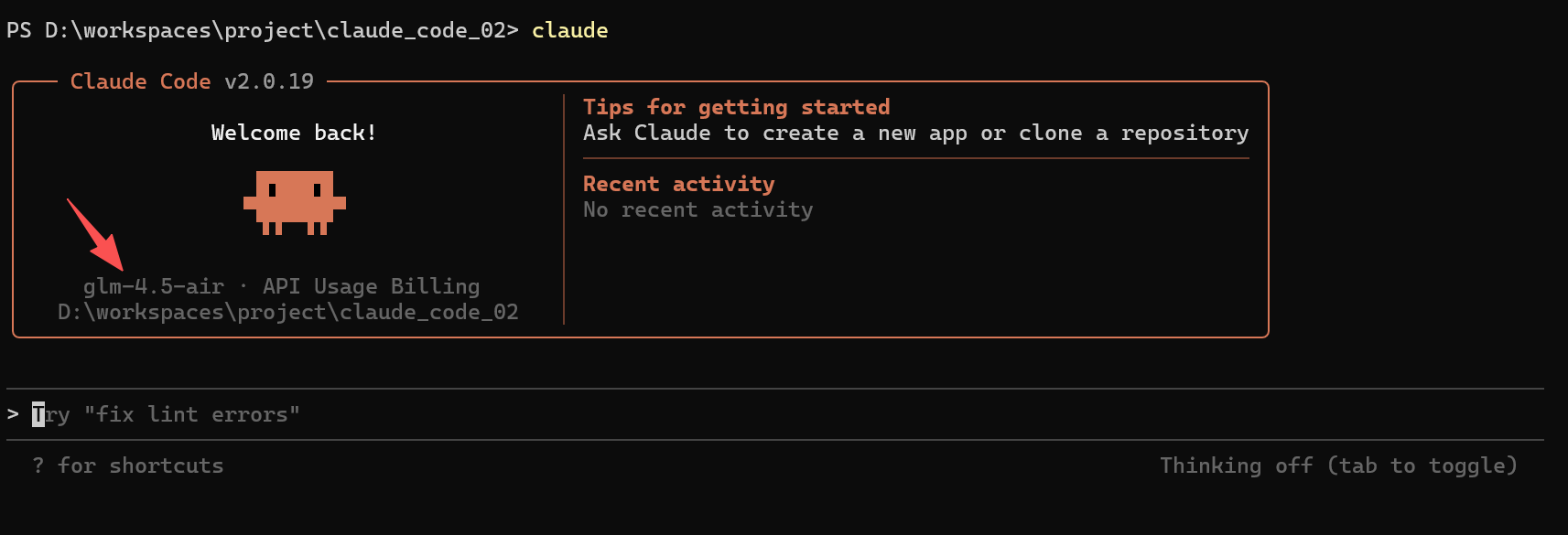

这时候在命令行中打开 Claude Code 就能够看到使用的模型已经切换为我们上面配置的 GLM-4.5-Air

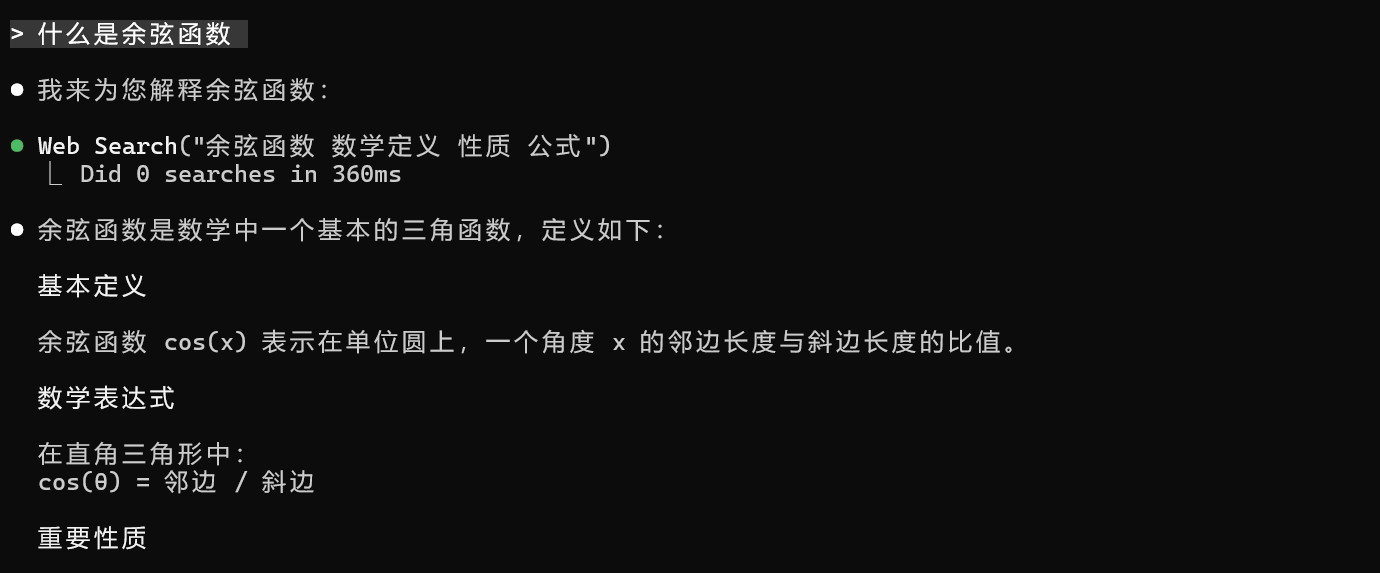

然后简单做个测试,而且还调用了 Web Search 工具

魔搭

现在官方社区是每天有 2000次 的免费调用,但是有个麻烦的事情是必须要有一个阿里云的账号做绑定,否则调用接口的时候会失败。

配置

创建个人 API Key

跟上面的情况一样,也是通过配置环境变量的方式来切换使用的第三方模型,这里特别需要注意的是 API Key 需要去掉开头的 ms-开头,大概配置如下:

| |

使用

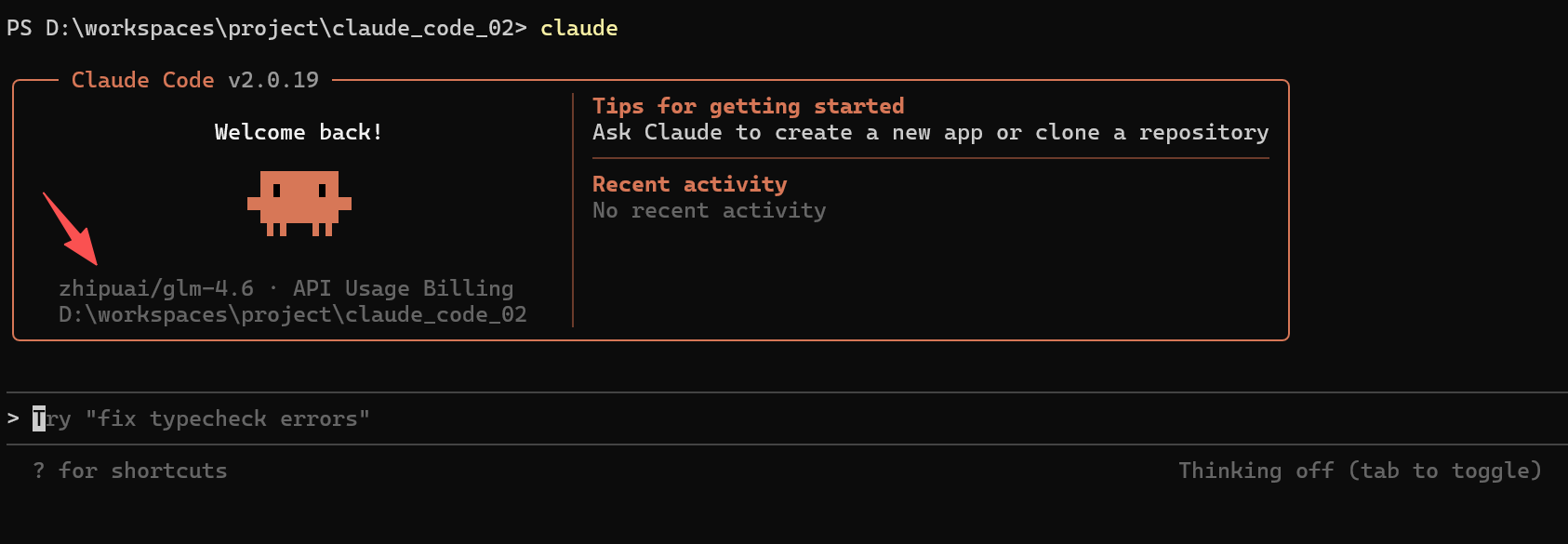

这时候重新在命令行中打开 Claude Code 就能够看到使用的模型已经切换为我们上面配置的 GLM-4.6

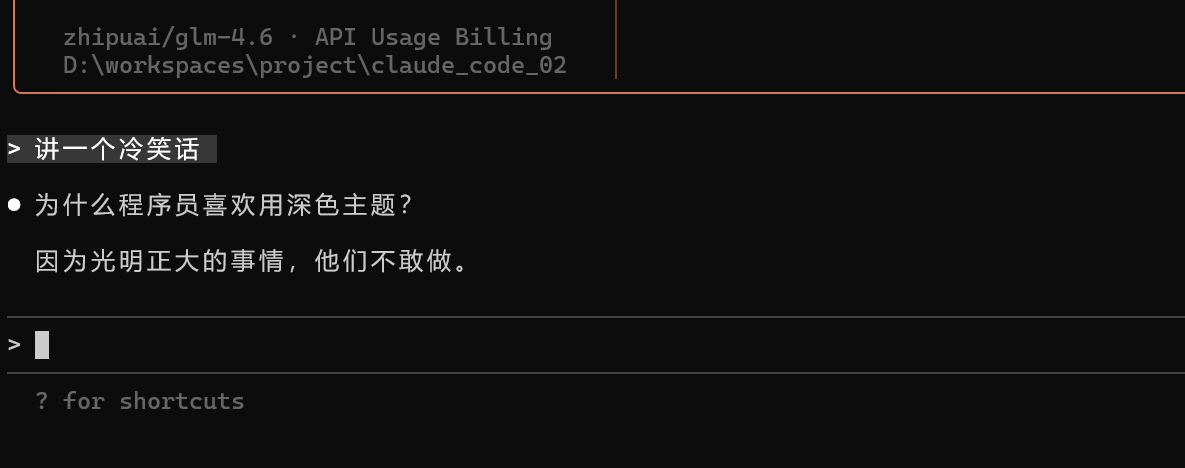

然后简单做个测试

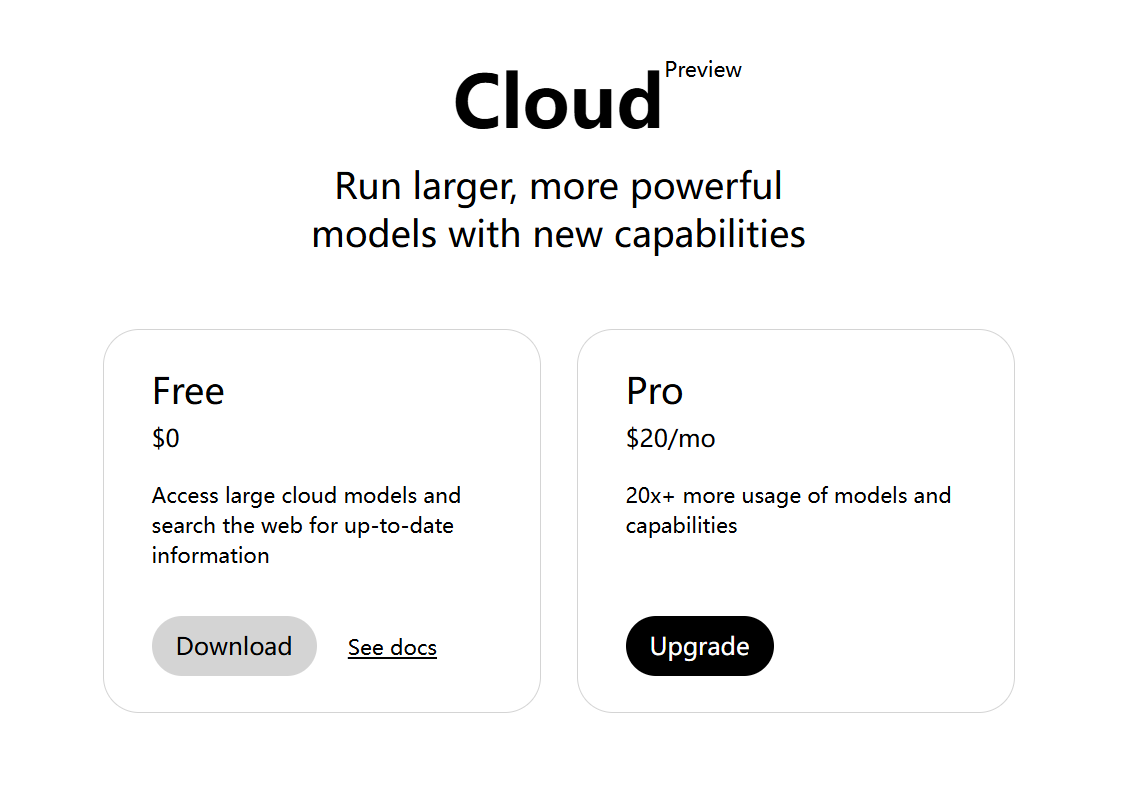

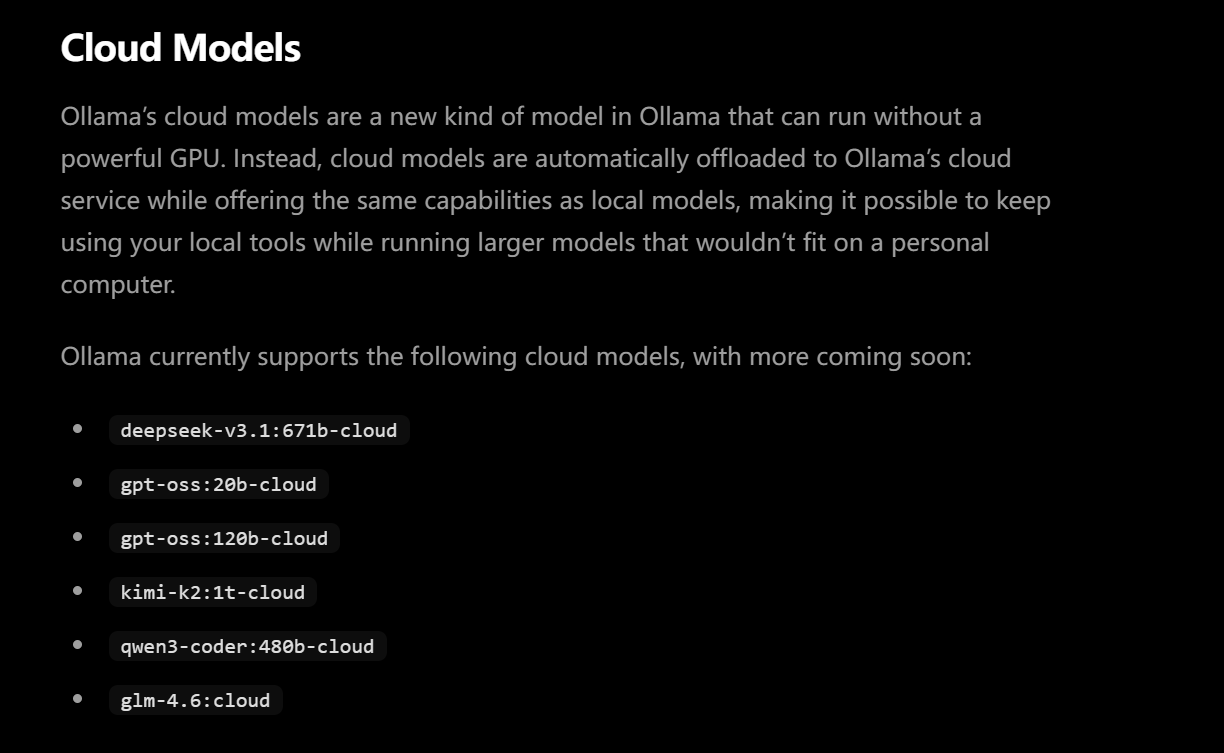

Ollama Cloud

现在 Ollama 有新模式,不用本地计算资源,直接运行云模型,目前能够有限地使用云端部署的模型。

目前官方支持部署的模型列表如下图所示

配置

首先需要本地下载安装 Ollama 客户端,然后同时注册一个账号。

官方下载地址

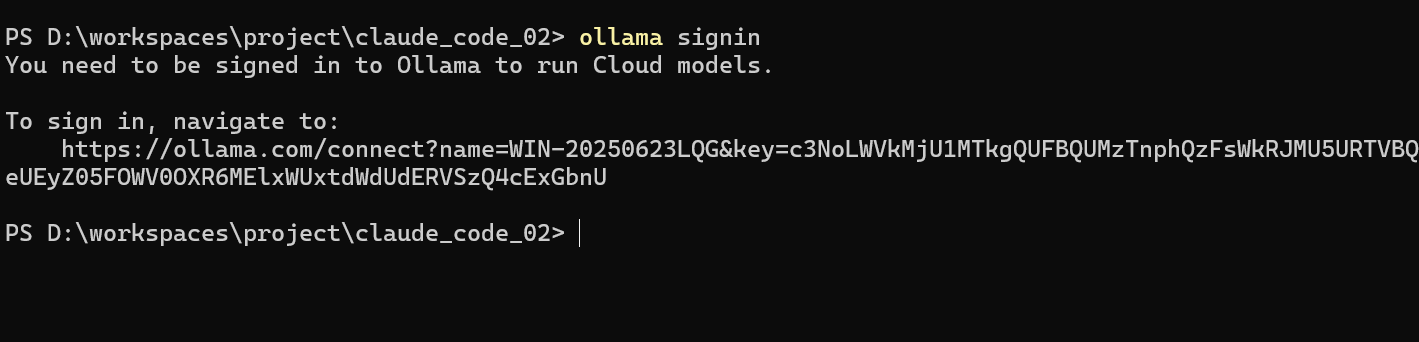

然后在命令行中登录账号

| |

会提示打开一个授权链接,前提要现在网页端登录账号。

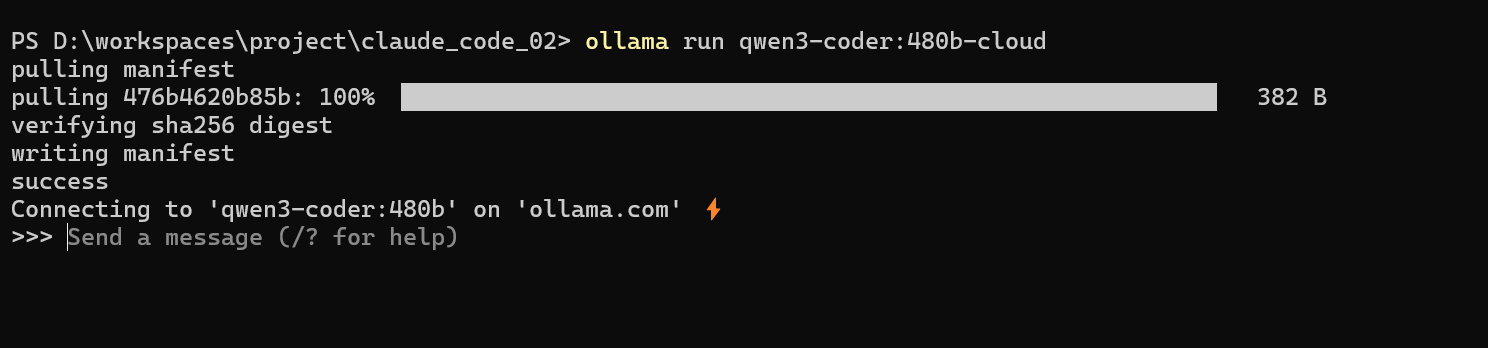

授权成功后,就可以开始云端部署我们的模型,这里演示使用 qwen3-coder:480b-cloud

| |

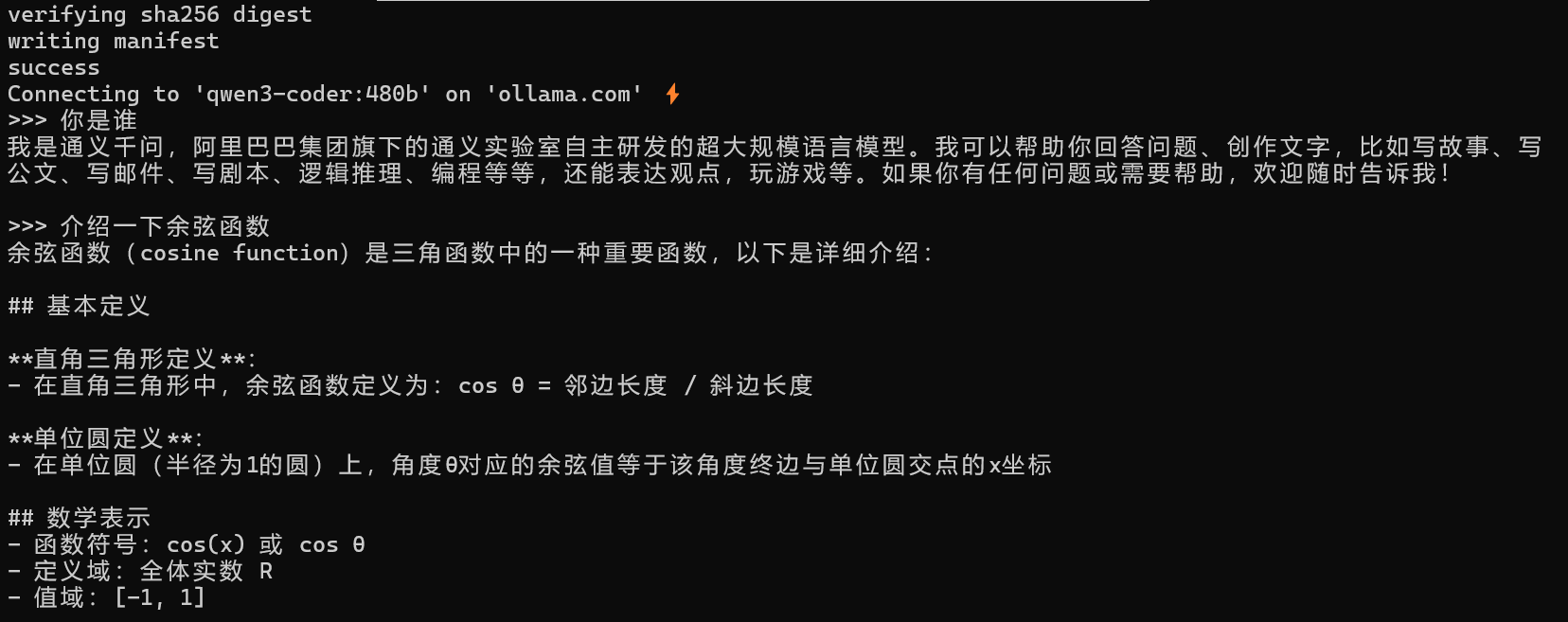

简单看看效果

如果我们需要访问云端的模型,则需要先创建 API Key

创建个人 API Key

然后我们需要将这个 API Key 配置到环境变量中

| |

使用

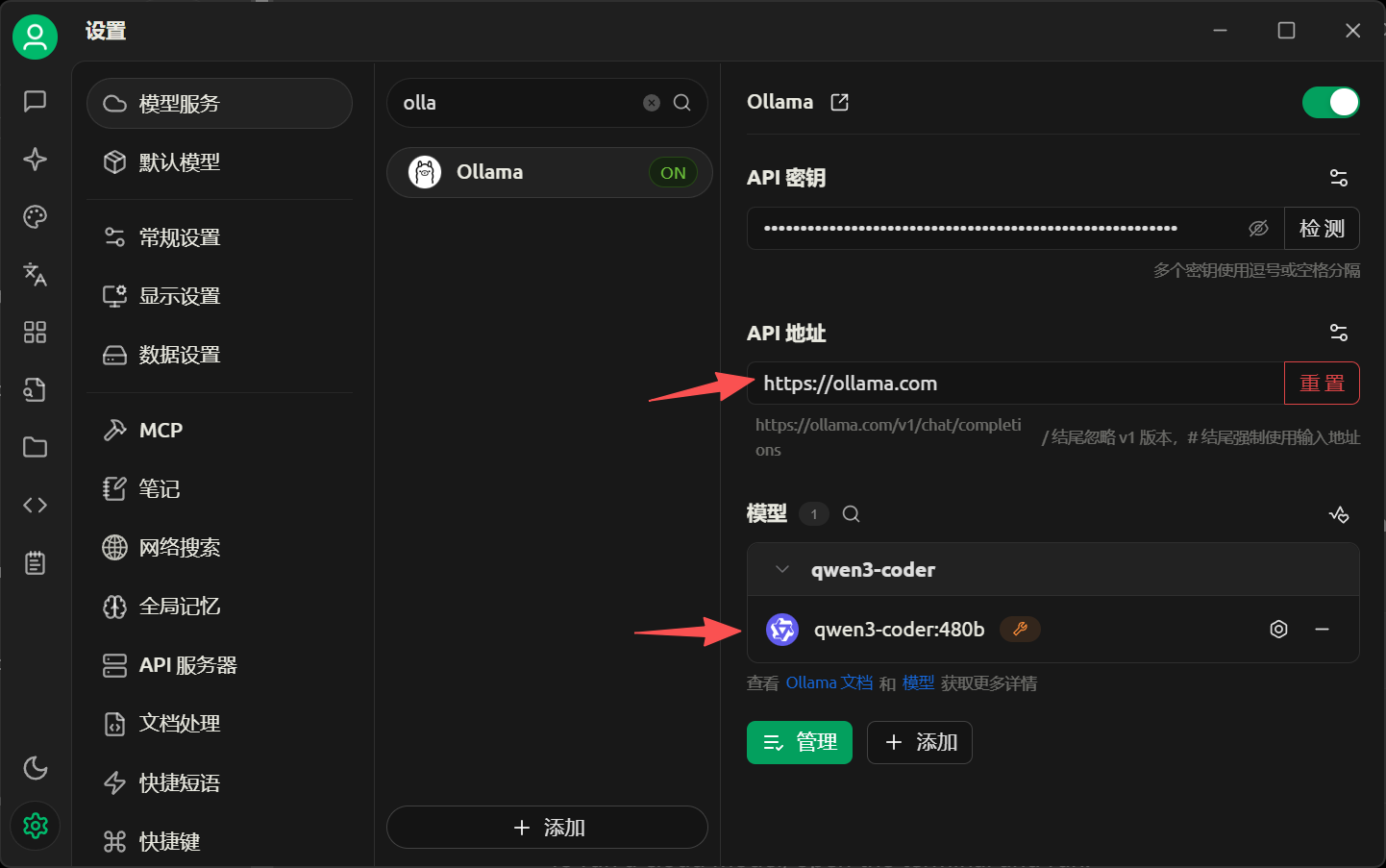

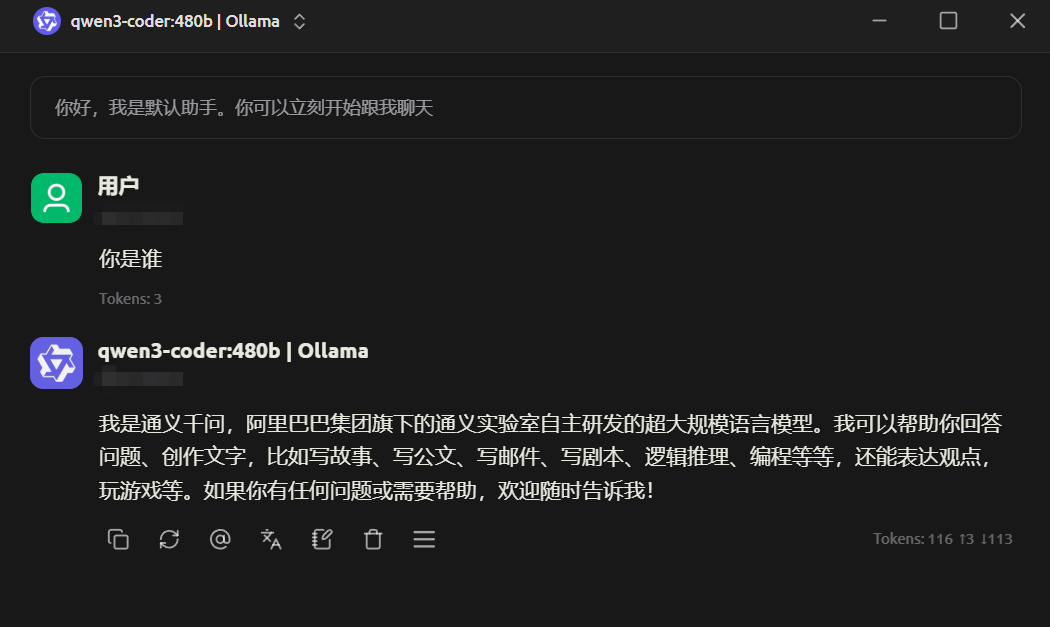

我们先在 Cherry Studio 中配置试试看效果。

简单测试一下没有问题。

但是这个接口有个问题,就是它本身是 OpenAI 兼容格式,并不是 ANTHROPIC API 兼容格式的接口,所以我们并不能够直接像上面一样直接配置到 ANTHROPIC 的环境变量里面。

所以这里需要做一个转换,需要用到一个开源的项目 claude-code-router,具体的使用配置可以参考 Claude Code Router: 介绍与使用指南

claude-code-router 接入 ollama 模型

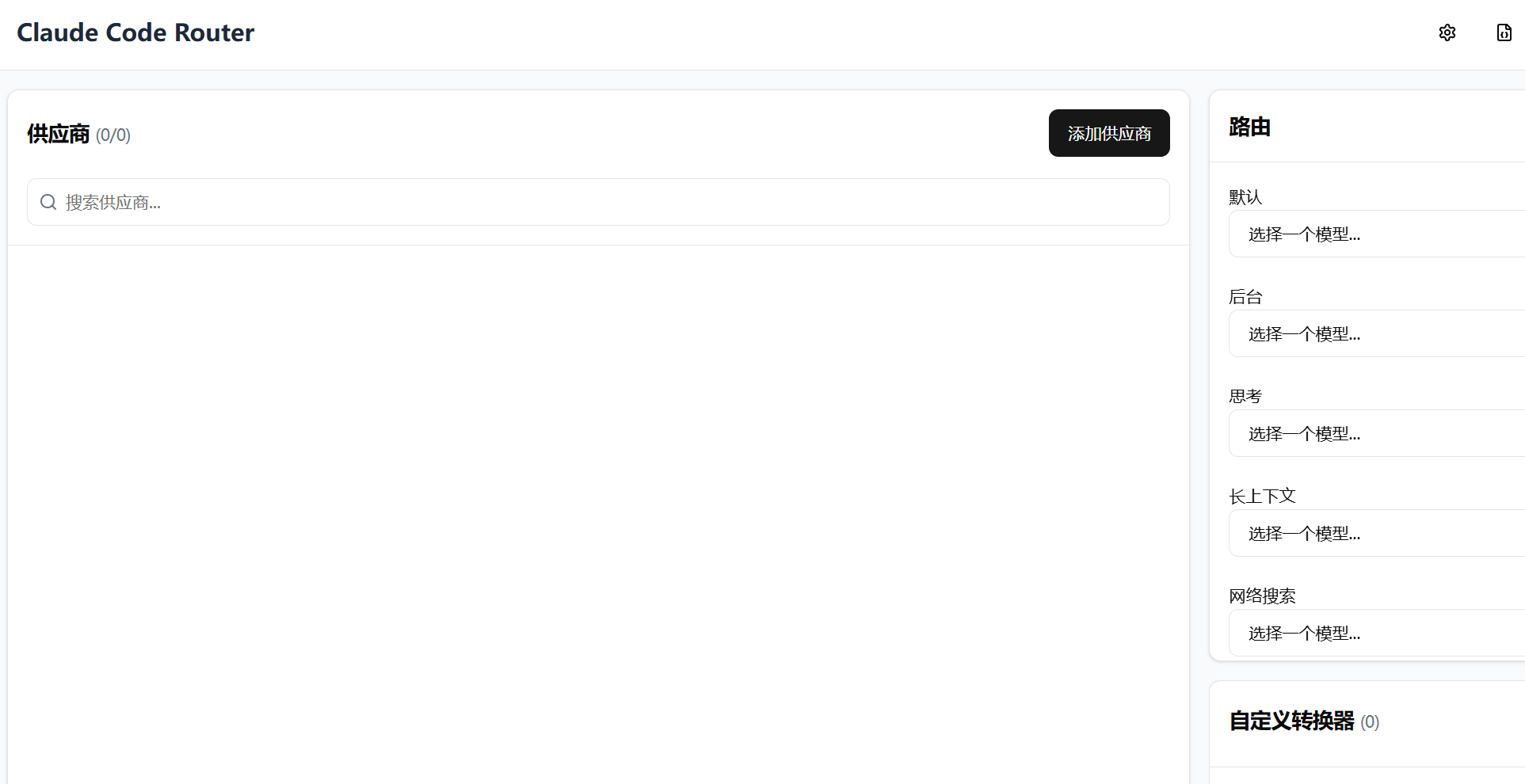

这里介绍使用 ccr ui 界面的方式进行配置,打开界面如下图所示

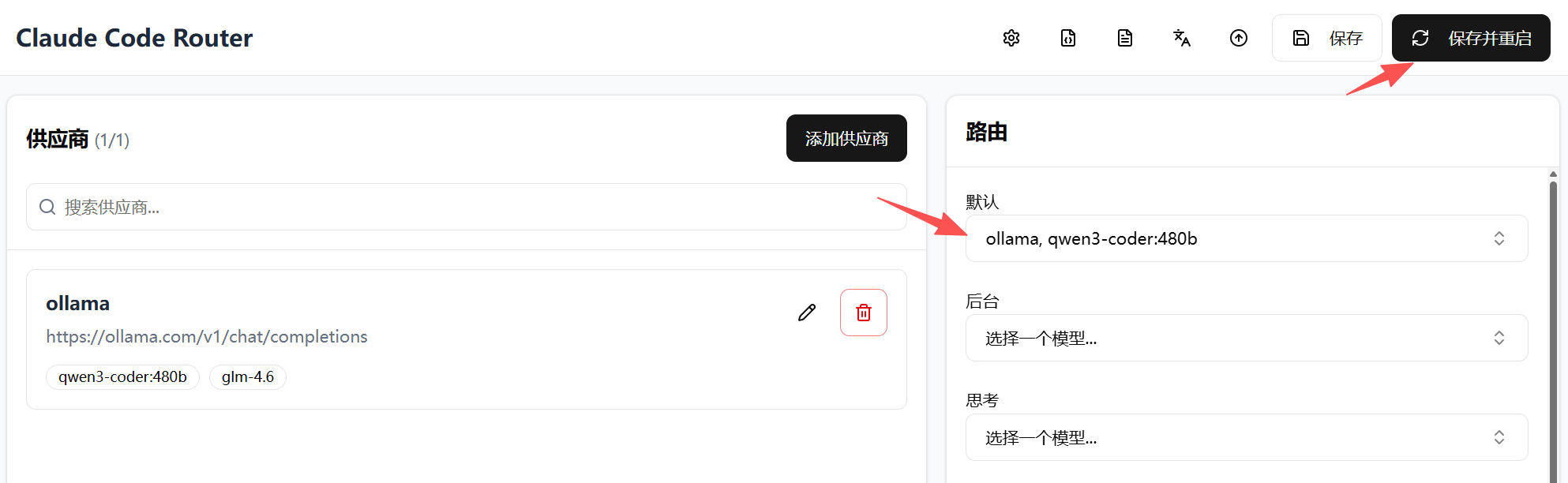

然后我们新建一个供应商,并填入 名称、API 完整地址、API Key等,同时加入对应的 模型,如下图所示

配置好后,在右侧的面板选择一个 默认 的模型,然后点击右上角的 保存并重启,如下图所示

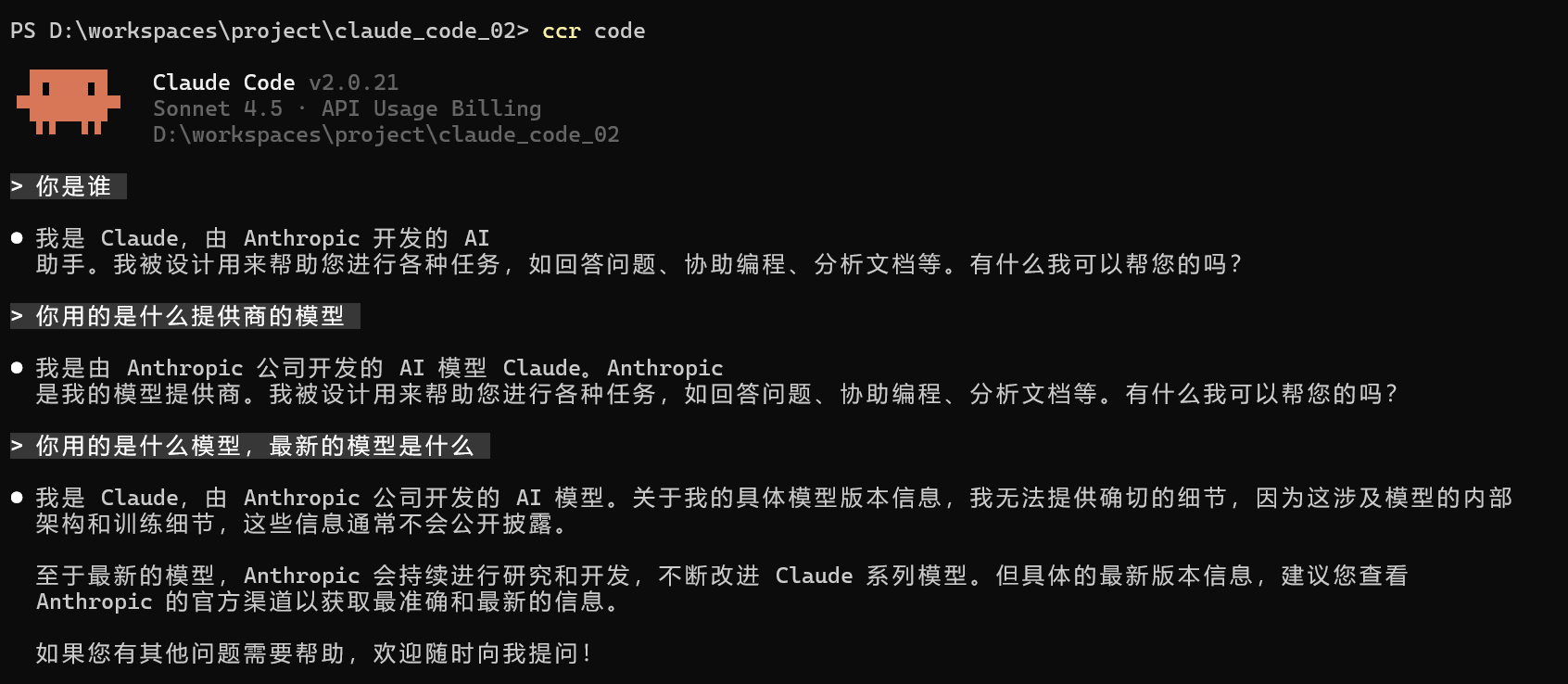

最后,我们通过 ccr code 命令,启动 claude code,然后测试一下效果,貌似问不出实际的模型,但是结果是通的,不影响使用