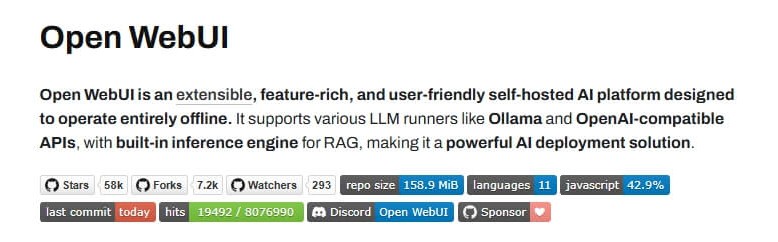

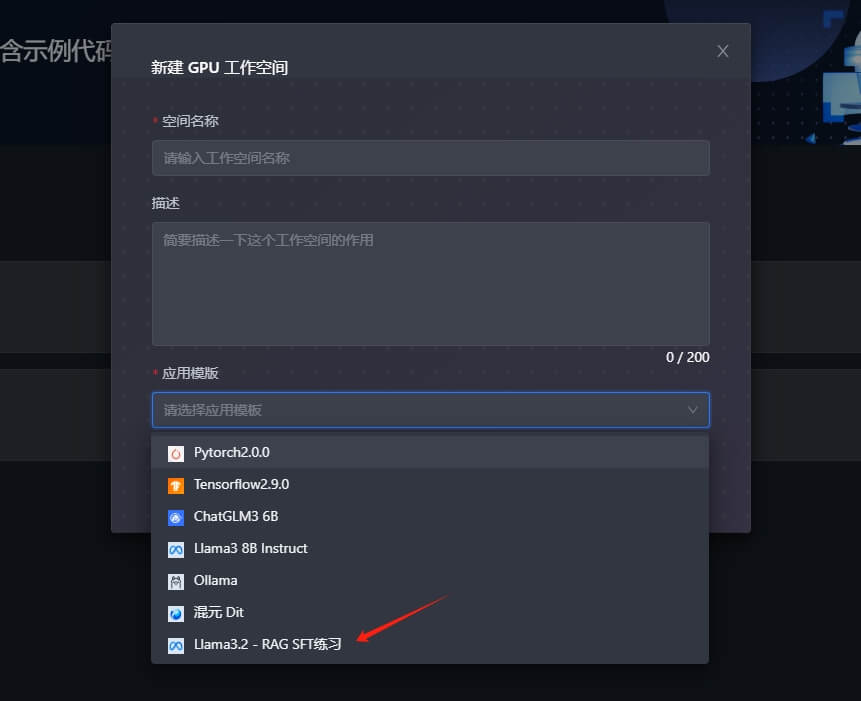

使用 Cloud Studio 的 Llama 3.2 模板,拥有将近 500G 的磁盘空间,足够在里面创建我们的模型应用,例如用 open-webui 搭建我们的个人知识库

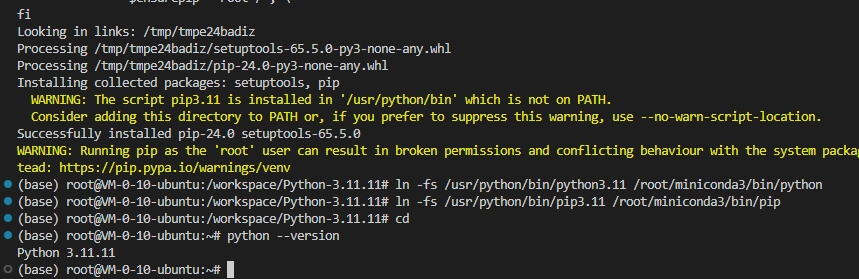

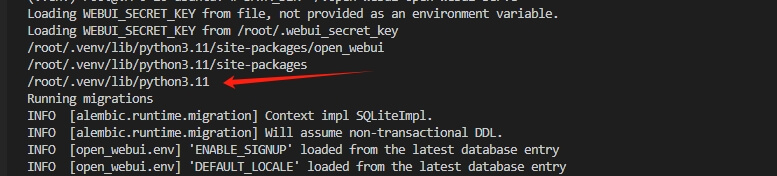

升级 Python 版本至 3.11.x

由于通过 pip 安装 open-webui 需要至少 python 3.11 版本,但是目前空间中预先安装的是 3.10 版本,所以我们需要先进行升级

安装依赖

| |

下载与安装

| |

建立软链接

| |

安装命令行环境

| |

安装 open-webui

官方推荐使用 uv 虚拟环境安装,更多的说明可以查看 官方文档

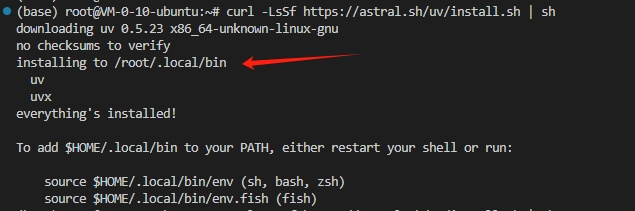

安装 uv

| |

建立软链接

安装后,默认是在 /root/.local/bin,需要关联到当前用户环境上

| |

配置源

| |

创建虚拟环境

| |

安装 open-webui

激活虚拟环境

| |

安装 open-webui

| |

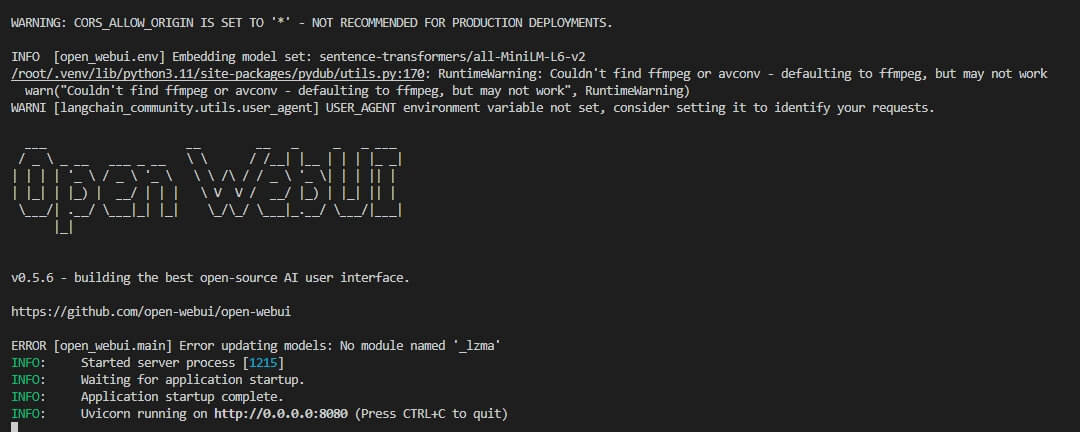

处理 sqlite3 问题

如果直接运行的话,会提示类似 Your system has an unsupported version of sqlite3. Chroma requires sqlite3 >= 3.35.0 这样的错误,这是由于 linux 系统本身软件源的版本比较低,所以我们需要额外处理安装

安装 pysqlite3-binary

| |

编辑 chromadb

导 chromadb 包时,覆盖原 sqlite3 库,修改以下内容

| |

在开头添加 3 行代码

| |

运行 open-webui

| |

安装 ollama 和 Ngrok

可参考 Cloud Studio 软件环境安装 的相关步骤

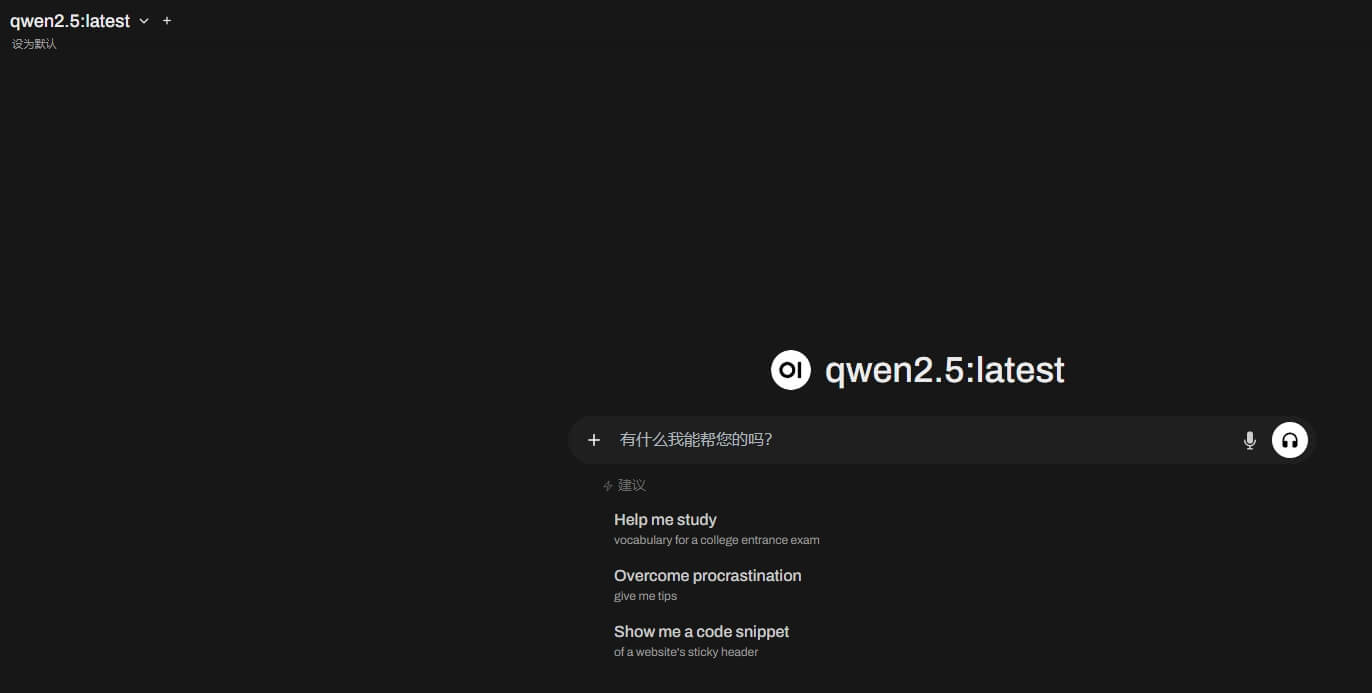

实际运行效果

刚开始进来的时候,可能会卡住,因为它会尝试去请求一些大模型的 API,例如 openai,国内是访问不到的,这里需要配置一个超时的环境配置

在项目启动的时候会打印几个目录的信息,其中如下图所示,稍后我们需要将配置文件放在这个目录

创建 .env 文件,并放置上面所示的目录下

| |

保存重启服务后,即可解决一直卡住的情况

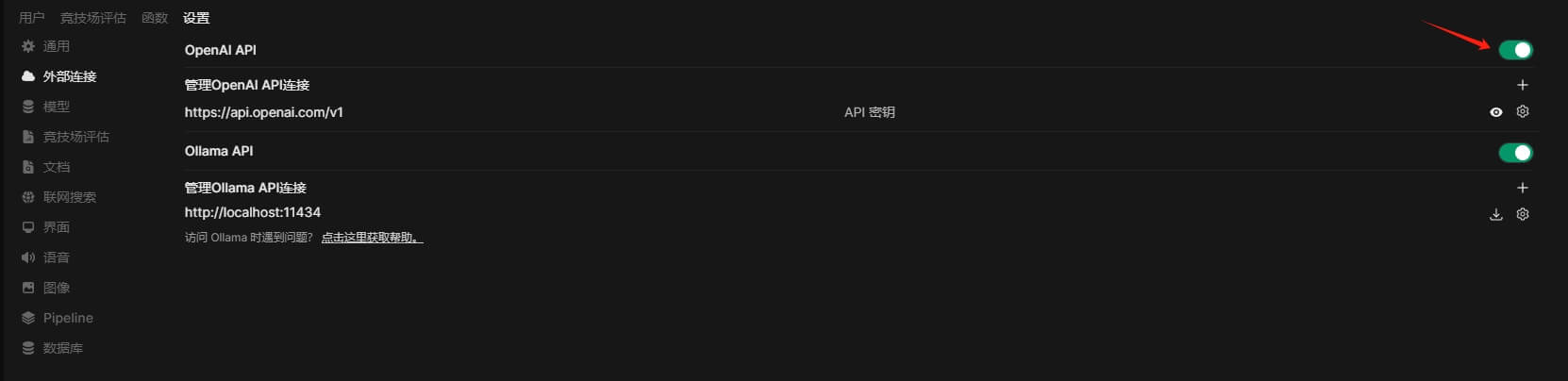

进入界面后,我们也可以选择将 openai 模型先关掉

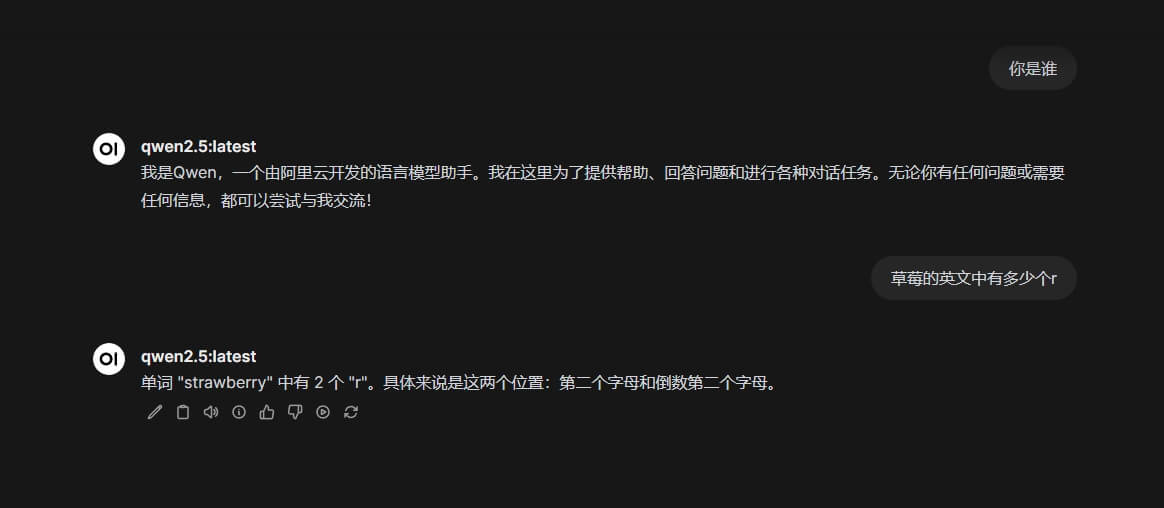

尝试了 qwen2.5 7b 模型,运行速度也挺快的

测试个人知识库

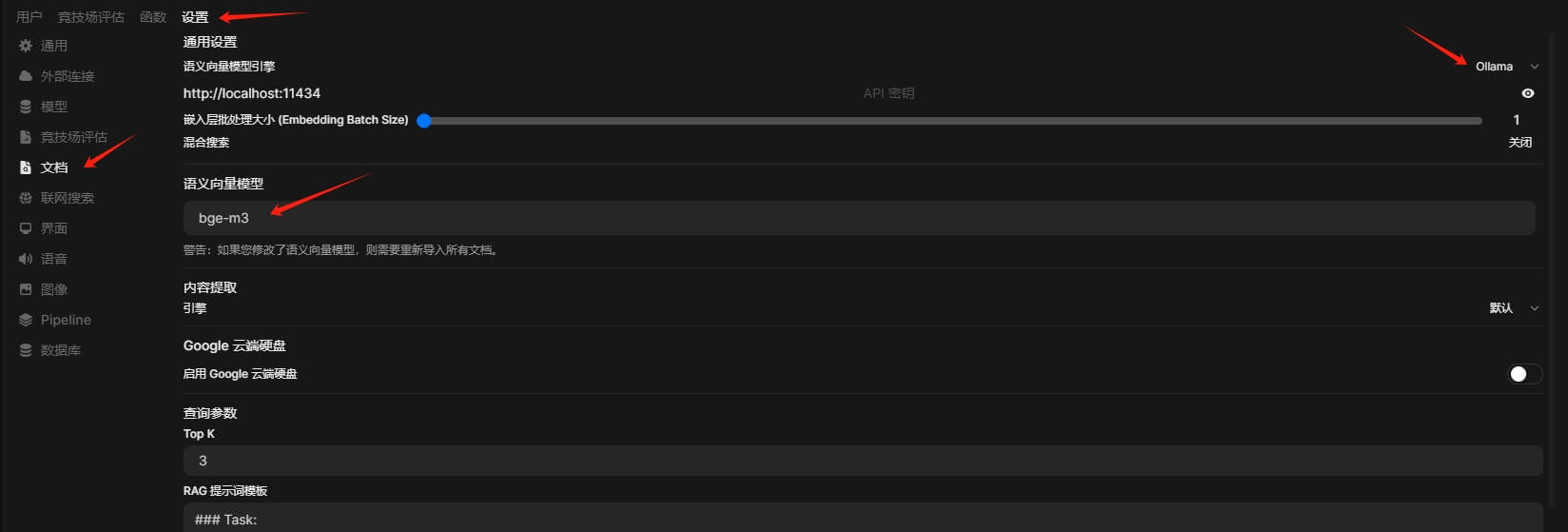

我们可以通过 ollama 拉取 bge-m3 模型,作为我们的向量化模型,并在管理员面板进行配置,记得配置完成后要点击底部的 保存 按钮

底部 PDF 图像处理 (使用 OCR) 这个地方也要开启

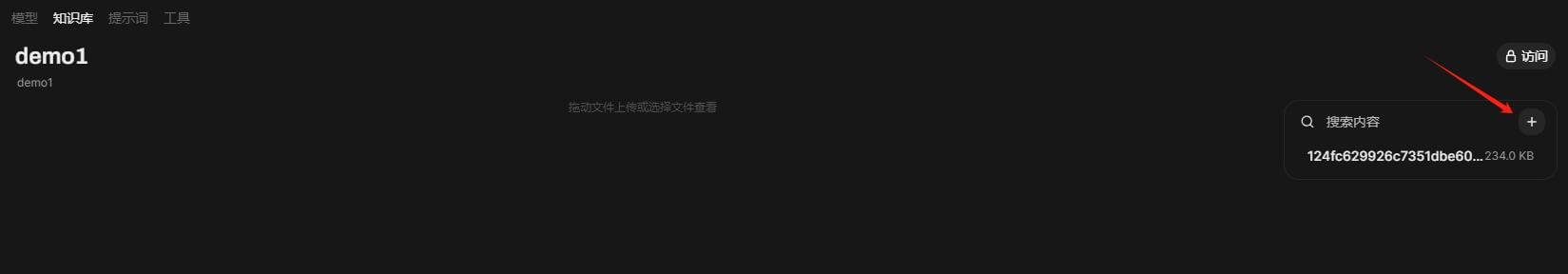

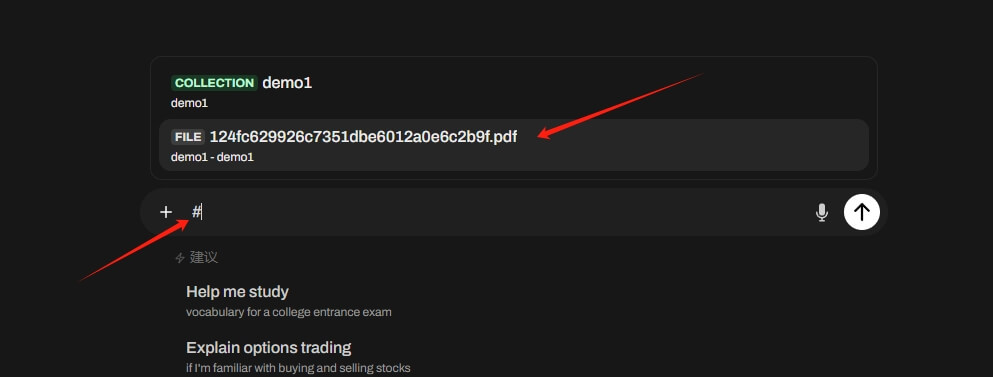

创建知识库

我们可以在顶部 知识库 的面板中,创建我们的知识库

然后我们可以上传文档的方式,构建我们的知识库

测试

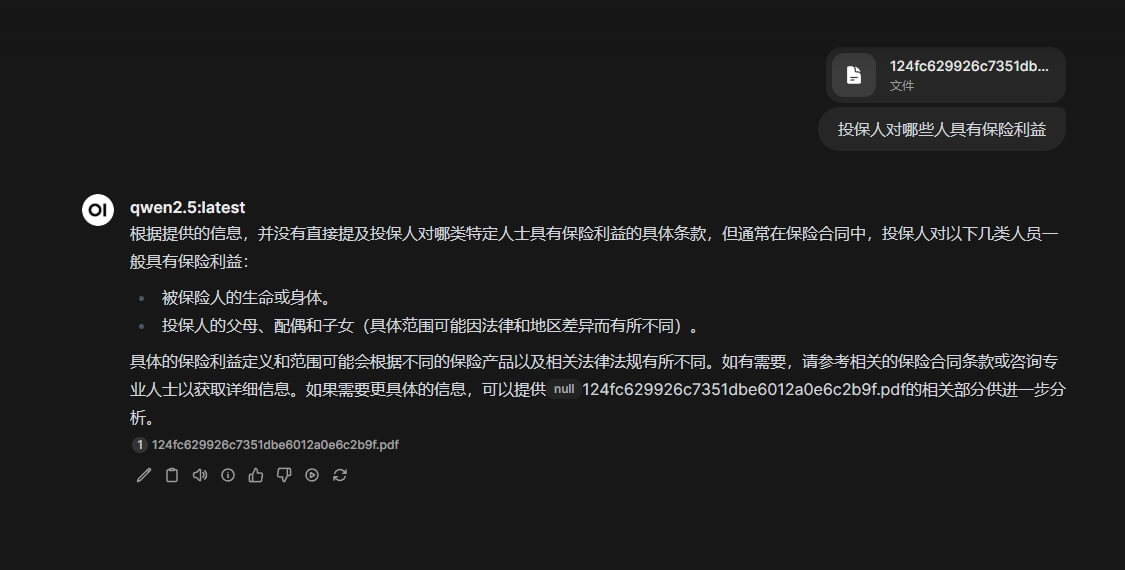

我们可以通过在对话框中使用指令 # 选择我们需要提问的文档,或者是我们整个知识库

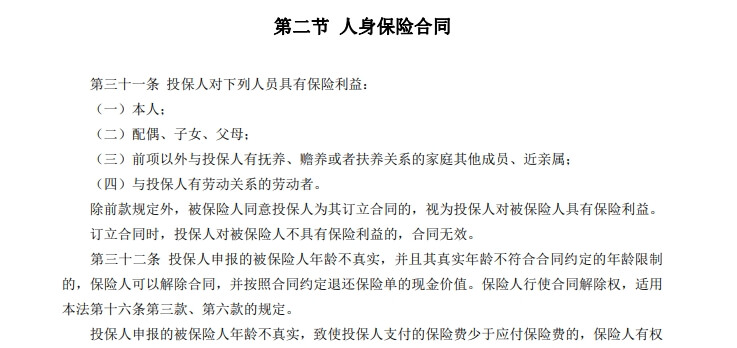

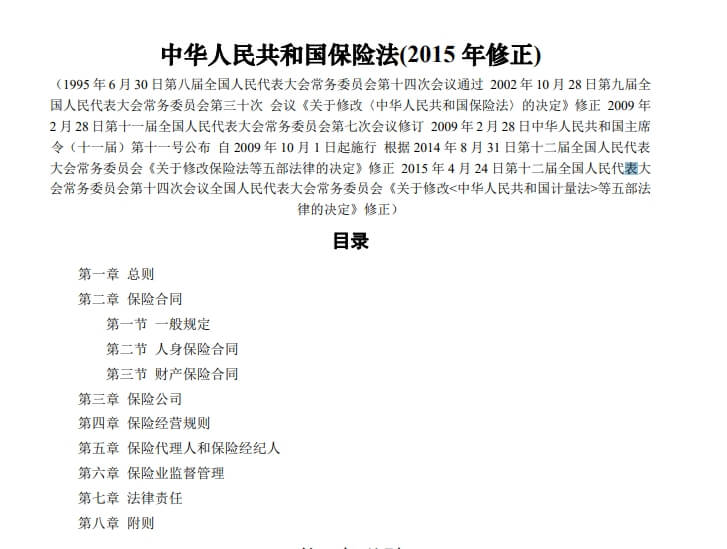

我这边找的是 保险法 的 pdf 文档

询问 投保人对哪些人具有保险利益

原本内容